|

|

|

发布时间: 2021-03-16 |

遥感图像处理 |

|

|

|

收稿日期: 2020-02-25; 修回日期: 2020-04-17; 预印本日期: 2020-04-24

基金项目: 国家重点研发计划项目(2017YFB0504000)

作者简介:

徐知宇, 1996年生, 女, 硕士研究生, 主要研究方向为基于深度学习的人居环境信息提取和分析评价。E-mail: xuzhiyu@aircas.ac.cn;

周艺, 通信作者, 女, 研究员, 主要研究方向为人居环境遥感。E-mail: zhouyi@aircas.ac.cn; 王世新, 男, 研究员, 主要研究方向为灾害与环境遥感应用。E-mail: wangsx@aircas.ac.cn; 王丽涛, 男, 副研究员, 主要研究方向为灾害与环境遥感应用。E-mail: wanglt@aircas.ac.cn; 王振庆, 男, 博士研究生, 主要研究方向为深度学习语义分割与目标检测。E-mail: wangzhenqing19@mails.ucas.ac.cn

中图法分类号: TP79

文献标识码: A

文章编号: 1006-8961(2021)03-0700-14

|

摘要

目的 高分2号卫星(GF-2)是首颗民用高空间分辨率光学卫星,具有亚米级高空间分辨率与宽覆盖结合的显著特点,为城市绿地信息提取等多领域提供了重要的数据支撑。本文利用GF-2卫星多光谱遥感影像,将一种改进的U-Net卷积神经网络首次应用于城市绿地分类,提出一种面向高分遥感影像的城市绿地自动分类提取技术。方法 先针对小样本训练集容易产生的过拟合问题对U-Net网络进行改进,添加批标准化(batch normalization,BN)和dropout层获得U-Net+模型;再采用随机裁剪和随机数据增强的方式扩充数据集,使得在充分利用影像信息的同时保证样本随机性,增强模型稳定性。结果 将U-Net+模型与最大似然法(maximum likelihood estimation,MLE)、神经网络(neural networks,NNs)和支持向量机(support vector machine,SVM)3种传统分类方法以及U-Net、SegNet和DeepLabv3+这3种深度学习语义分割模型进行分类结果精度对比。改进后的U-Net+模型能有效防止过拟合,模型总体分类精度比改进前提高了1.06%。基于改进的U-Net+模型的城市绿地总体分类精度为92.73%,平均F1分数为91.85%。各分类方法按照总体分类精度从大到小依次为U-Net+(92.73%)、U-Net (91.67%)、SegNet (88.98%)、DeepLabv3+(87.41%)、SVM (81.32%)、NNs (79.92%)和MLE (77.21%)。深度学习城市绿地分类方法能充分挖掘数据的光谱、纹理及潜在特征信息,有效降低分类过程中产生的"椒盐噪声",具有较好的样本容错能力,比传统遥感分类方法更适用于城市绿地信息提取。结论 改进后的U-Net+卷积神经网络模型能够有效提升高分遥感影像城市绿地自动分类提取精度,为城市绿地分类提供了一种新的智能解译方法。

关键词

城市绿地; 卷积神经网络; U-Net; 高分遥感; 语义分割

Abstract

Objective High-precision monitoring of the spatial distribution of urban green space has important social, economic, and ecological benefits for optimizing the spatial structure of such space, maintaining urban ecological balance, and developing green city construction. As the first civilian optical satellite with high spatial resolution, Gaofen2 (GF-2) exhibits the remarkable characteristics of sub-meter high spatial resolution and wide coverage. GF2 provides important data support to multiple fields, such as urban environmental monitoring and urban green space information extraction. However, traditional classification methods still encounter many problems. For example, training a method to be an effective classifier for massive data is difficult, and the accuracy of classification results is generally low. The use of massive high-resolution remote sensing images to achieve large-scale rapid and accurate urban green space distribution extraction is an urgent task for urban planning managers. With the rapid development of deep learning technology, full convolutional networks (FCN) provide novel creative possibilities for semantic segmentation and realize pixel-level classification of images in the field of deep learning for the first time. Inspired by the U-Net network structure, we applied an improved U-Net to urban green space classification for the first time and proposed an automatic classification technique for urban green space by using high-resolution remote sensing images. Method First, we improved the U-Net model to obtain the U-Net+ model. The main structure of U-Net+ is composed of an encoder and a decoder that can achieve end-to-end training. The encoding channel realizes the multi-scale feature recognition of an image through four-time maximum pooling, and the decoding channel restores the position and detailed information of an image through upsampling. The network uses skip connection to realize the fusion of feature information with the same scale at different levels, overcoming accuracy loss caused by upsampling. In addition, we improved the model by adding batch normalization (BN) after each layer of network convolution operation, effectively regulating the input of the network layer and improving model training speed and network generalization capability. To solve the overfitting problem, which is easily produced by the limited sample training set, we added the dropout layer with a 50% probability of dropping neurons after the convolution operation of the fourth and fifth layers of the network. Second, deep learning requires a large amount of label data related to the classification objectives for training. However, existing open-source datasets cannot meet the requirements of the urban green space classification task. Manually establishing an urban green space tag dataset is necessary. We selected three typical urban green space sample areas in Beijing (urban parks, residential areas, and golf courses) as study areas. By combining GF-2 images and Google Earth remote sensing images in summer and winter, we drew all types of urban green space in the study areas through visual interpretation by using ArcGIS. The visual interpretation results are corrected with actual field investigation. Third, random cropping and data augmentation techniques are adopted to expand the dataset, ensuring the randomness of the samples and enhancing the stability of the model while fully utilizing image information. We adopt the Adam optimizer with an initial learning rate of 0.000 1. Result 1) The overall classification accuracy of the U-Net+ model is improved by 1.06% compared with that of the original U-Net. After 40 training epochs, the accuracy of the U-Net+ model reaches a high level, and the loss function realizes rapid convergence. The U-Net+ model effectively prevents overfitting and improves generalization capability. 2) To verify the effectiveness of our method, the classification accuracy of the U-Net+ results is compared with those of three traditional classification methods, namely, maximum likelihood estimation (MLE), neural networks (NNs), and support vector machine (SVM), and three semantic segmentation models, i.e., U-Net, SegNet, and DeepLabv3+. Among the seven classification methods, the U-Net+ model achieves the highest overall classification accuracy for urban green space. The seven classification methods are arranged in order of classification accuracy from large to small: U-Net+ (92.73%) > U-Net (91.67%) > SegNet (88.98%) > DeepLabv3+ (87.41%) > SVM (81.32%) > NNs (79.92%) > MLE (77.21%). 3) In the three types of urban green space, evergreen trees have the highest classification accuracy (F1=93.65%), followed by grassland (F1=92.55%) and deciduous trees (F1=86.55%). 4) Deep learning exhibits strong fault-tolerant capability for training samples. By training and learning a large number of label data, it can effectively reduce the impact of errors and improve recognition capability, making it more suitable for urban green space information extraction than traditional remote sensing classification methods. Conclusion Deep learning urban green space classification methods can fully mine the spectral, textural, and potential feature information of data. Meanwhile, the U-Net+ model proposed in this study can also effectively reduce the salt-and-pepper noise the classification process and realize high-precision pixel-level classification of urban green space. The improved U-Net+ can effectively improve the accuracy of automatic classification of urban green space in high-resolution remote sensing images and provide a new intelligent interpretation method for urban green space classification in the future.

Key words

urban green space; convolutional neural network (CNN); U-Net; high-resolution remote sensing; semantic segmentation

0 引言

城市绿地作为改善城市自然生态和生活环境的“净化器”,是现代城市生活和生产不可或缺的一部分。城市绿地现状信息的实时、高效、精细化监测,对城市生态环境建设,提高城市生态效益具有重要意义(Qian等,2015)。然而城市绿地遥感影像分类是一个复杂的数据处理过程,尤其是高分辨率遥感影像的城市绿地分类存在很多困难:1)城市绿地的植被类型多样,多光谱特征差异显著;2)绿地斑块具有高度异质性和分散性,形状破碎且不规则;3)高分辨率遥感影像提供地物的高清细节信息的同时,也增大了类内差异(刘大伟等,2016)。现有影像分类方法对数据本身的要求严格,难以从海量数据中训练出有效分类器以充分挖掘数据之间的关联,泛化能力较弱,过程耗时耗力且难以得到更好的分类效果。

深度学习(deep learning)逐渐成为人工神经网络研究的热点和前沿。深度学习是Hinton等人(2006)基于人脑学习的思想,提出的一种深度神经网络的机器学习方法。相对BP(back propagation)神经网络、支持向量机等“浅层”神经网络方法而言,深度神经网络的优势在于能够更充分挖掘海量数据中的光谱、纹理及潜在特征信息,智能地进行特征选择与特征工程构建,在影像分类中取得较好的分类结果。全卷积神经网络(fully convolutional network,FCN)(Long等,2015)的提出,打开了深度学习语义分割的大门,首次实现了深度学习图像的像素级分类。U-Net模型(Ronneberger等,2015)在FCN基础上进行改进,结合了反卷积网络与跳跃结构,在遥感影像分类中取得了一定的研究成果(Zhang等,2018)。深度学习图像分类技术已经广泛用于建筑物提取(Liu等,2019)、土地分类(Helber等,2018)、作物分类(Kussul等,2017)和医学图像分类(Hirasawa等,2018)等领域,均取得了不错效果。

利用海量高分辨率遥感影像,开展大范围快速准确的城市绿地分布提取,是实现精细化城市绿地空间规划管理的当务之急。针对传统城市绿地影像分类存在的问题,本文将U-Net卷积神经网络首次应用于城市绿地分类,提出一种面向高分遥感影像的城市绿地自动分类提取技术。通过将改进的U-Net+模型与传统的分类模型和当前流行的深度学习语义分割模型进行对比,证明本文方法在城市绿地遥感分类中有着显著的优势,为今后城市绿地分类提供了一种新的智能解译方法。

1 研究区域与数据

1.1 研究区概况

北京作为中国的首都,是全国政治、文化和科技创新中心,是著名的现代化国际城市。北京市总面积16 410.54 km2,是典型的北温带半湿润大陆性季风气候,夏季高温多雨,冬季寒冷干燥,城市绿地主要集中于五环以内,主要种植暖温带落叶阔叶林和温性针叶林,形成了以青山相拥,三环环绕,十字绿轴,十条楔形绿地穿插,百余个城市公园和小微绿地为主的,由绿色通道串联成点、线、面、带、环相结合的城市绿地格局系统(北京市城市规划设计研究院,2010)。

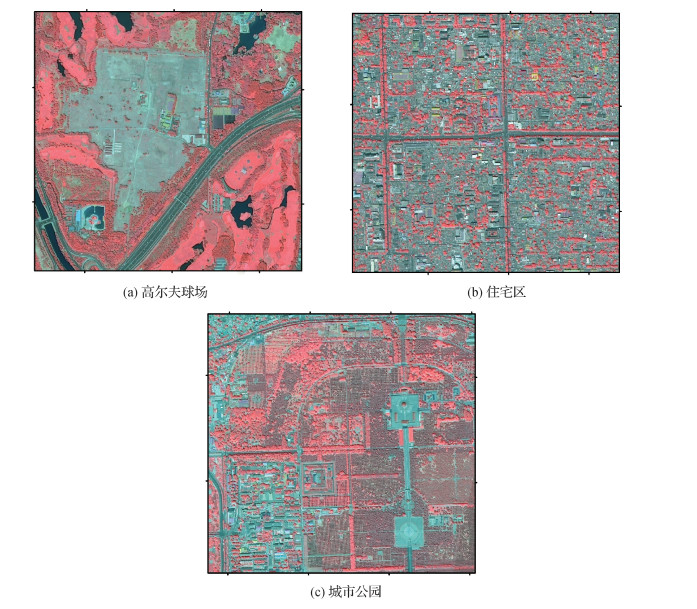

本文以北京市城市绿地为研究对象,根据城市绿地类型分布特点选取了3个典型研究区域,分别为城市公园(天坛公园)、住宅区(东城)和高尔夫球场(万柳高尔夫球场),如图 1所示。面积分别是2.56 km2、2.56 km2和2.42 km2。城市公园绿地作为城市绿地系统中的主要场所,分布相对集中独立,植被类型多样,具有观赏游憩功能;住宅区绿地主要包括住宅小区庭院绿地、花园绿地和交通运输用地中的附属绿地,分布较破碎零散;高尔夫球场主要以人工草地为主,绿地种植较为规则,具有辨识度高的特点。这3个样本区可以基本覆盖北京市城市绿地典型类型,减少数据量冗余带来的工作量,提高分析效率。

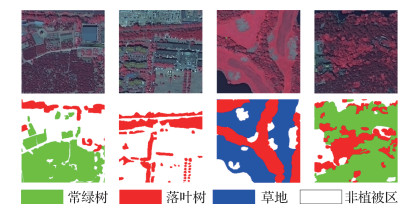

1.2 绿地分类

北京市常用绿地植被可归纳为3种绿地类型:常绿树,落叶树和草地。其中常绿树主要包括雪松、侧柏、圆柏、白皮松、樟子松、华山松、油松、乔松、白杄、冬青卫矛、叉子圆柏和锦熟黄杨等松柏类乔木和冬青卫矛等灌木;落叶树种类繁多,覆盖范围较广,主要包括梧桐、银杏、白蜡树、玉兰、水杉、海棠、合欢、椿树、红枫、白桦、黄金树、梓树、山楂、杜仲、樱桃、杏树、槐树、丁香、柳树、榆树、枣树、竹、蜡梅、流苏、卫矛、连翘、圆锥绣球、木槿、迎春花、枸杞和金叶女贞等;草地包括人工草地和天然草地(吴丽娟,2006)。各植物类型及对应的遥感解译特征如表 1所示。

表 1

北京市常用植物类型及对应遥感解译特征

Table 1

Common plant types and corresponding remote sensing interpretation features in Beijing

| 类别 | 种类 | 解译特征 | 标准假彩色 |

| 常绿树 | 雪松、侧柏等 | 色调呈暗红色,纹理排列清晰,多分布于公园 |

|

| 落叶树 | 梧桐、银杏等 | 色调呈红色,纹理粗糙,多分布于公园、居民区、道路两旁 |

|

| 草地 | 人工草地、天然草地 | 色调呈浅红色,纹理均匀,分布于高尔夫球场、公园 |

|

1.3 数据源与数据预处理

本文以国产高分2号(GF-2)卫星多光谱影像为主要研究数据(数据来源于中国资源卫星应用中心,获取时间为2019年5月)。高分2号PMS(panchromatic multispectral sensor)传感器具有1个0.8 m空间分辨率的全色波段和4个3.2 m空间分辨率的多光谱波段,通过正射校正、影像融合、影像镶嵌与裁剪等预处理,得到研究区空间分辨率为1 m、位深8 bit的GF-2影像。为了更好地表征城市绿地的植被特征,本文采用432波段组合的标准假彩色影像进行城市绿地分类提取。

深度学习需要大量与分类目标有关的标签数据进行训练,而现有的开源数据集无法满足本文分类任务需求,因此需要人工建立城市绿地标签数据集。结合GF-2与Google earth夏季和冬季高分辨率遥感影像,通过人工目视解译的方式勾绘出实验区影像中所有的绿地类型轮廓,通过实地调查对3种绿地目视解译结果进行校正,结果存为8 bit的栅格图像,即为地表真实标签数据,其中,1代表常绿树,2代表落叶树,3代表草地,0代表其他。将处理好的影像数据和对应标签数据按照面积比例3 ∶1 ∶1划分成训练区、测试区和验证区,保证训练、测试、验证不存在交叉重叠,通过随机裁剪扩充训练集和测试集样本量,弱化背景噪声,最终获得训练集样本图像1 500幅,测试集样本图像500幅,如图 2所示。

2 基于U-Net+模型的城市绿地分类方法

本文在U-Net深度学习模型的基础上加以改进,构建了基于高分2号遥感影像的城市绿地自动分类提取方法。首先在制作好的数据集上对改进后的U-Net+模型进行训练,得到最佳参数组合。然后预测得到北京市五环区域的城市绿地分类图。为了验证本文方法的有效性,选取最大似然法(maximum likelihood estimate, MLE)、神经网络(neural networks, NNs)、支持向量机(support vector machine, SVM)、SegNet、DeepLabv3+和原始U-Net模型等6种分类方法进行对比分析。

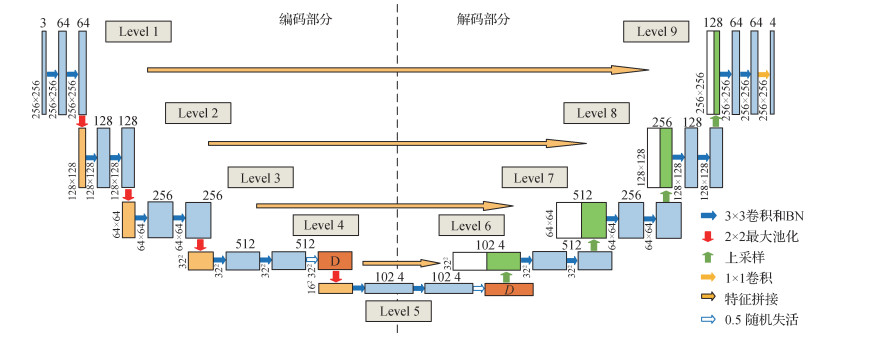

2.1 U-Net+卷积神经网络

U-Net卷积神经网络是Ronneberger等人(2015)提出的一种改进的FCN结构,是目前扩展性较好的全连接神经网络。其结构清晰呈现字母U形,由左半边的压缩通道和右半边扩展通道组成。与其他深度神经网络相比,U-Net模型的最大优势在于结合了编码—解码结构和多尺度特征融合的特点。压缩通道是一个编码器,通过4次最大池化实现网络对影像特征的多尺度特征识别。扩展通道是一个解码器,通过上采样还原影像的位置信息和细节信息。通过特征拼接(skip-connection)实现不同层次同尺度特征信息的融合,克服因上采样造成的精度损失问题,以优化分类结果。

目前,对U-Net模型的改进主要包括:1)通过增加高性能语义分割模块改进U-Net模型网络框架。Diakogiannis等人(2020)将U-Net编码解码结构与残差连接、金字塔池化等体系结合,提出一种深度学习架构ResUNet-a,用于高分辨遥感领域语义分割任务。Li等人(2018)使用DownBlock和UpBlock模块构建DeepUNet模型,用于海陆影像分类。2)通过改进损失函数提高模型性能。何凯明团队提出focal loss损失函数以解决样本不均衡问题(Lin等,2017)。3)结合多源特征数据提高深度学习模型分类精度。许慧敏等人(2019)结合nDSM数据可以有效提高U-Net模型的地形分类精度。

本文总结深度学习常用且有效的改进方法,对U-Net网络进行改进,提出了U-Net+模型,解决了U-Net模型对小样本训练中存在的过拟合问题,提高了模型的分类效果和泛化能力。

激活函数对神经网络学习和理解复杂分类问题具有重要作用,常用的有sigmoid函数和ReLU函数。当输入数据较大或较小时,sigmoid函数的导数趋近于零,存在饱和效应,故在反向传播阶段可能会因为梯度消失导致无法收敛。ReLU函数在提升网络稀疏性的同时减少了参数之间的依赖性,可以有效改善梯度消失,加快梯度下降收敛速度。本文提出的U-Net+模型沿用U-Net模型的激活函数策略,采用ReLU激活函数提高模型训练速度。

批标准化(batch normalization,BN)是Ioffe和Szegedy(2015)提出的一种改善神经网络性能和稳定性的设计模式,将数据分成小批次(batch size)进行随机梯度下降,计算机内部自动保存读取的每批数据均值和方差,在每批数据进行前向传递时,对每一层神经网络输入值都进行标准化处理,服从均值为0、方差为1的分布。本文提出的U-Net+模型在U-Net模型每层网络卷积操作后增加BN处理,可以有效规范网络层的输入,克服了因网络层数加深导致难以训练的问题,有助于梯度传播。

随机失活(dropout)是神经网络正则化的一种方式(Srivastava等,2014),在训练过程中通过将隐含层的部分权重或输出随机归零,降低节点间的相互依赖性,可以有效解决网络过拟合和梯度消失问题。本文提出的U-Net+模型在U-Net网络第4层和第5层卷积操作后添加概率为0.5的dropout层,通过丢弃50%概率的神经元减少数据过拟合现象。

针对遥感影像人工构建的标签数据集数量有限的问题,本文提出的U-Net+模型采取随机裁剪(random crop)和随机数据增强(random data augmentation)的方式扩充样本量。随机裁剪可以通过控制裁剪数量保证3个样本区3种绿地训练样本的比例相近,能够高效大量扩充训练样本量。与规则格网裁剪和滑动窗口裁剪相比,随机裁剪能获取更多的图像数量,且不会造成过度的数据冗余,保证样本随机性的同时可以有效学习数据信息。随机数据增强也是一种降低过拟合的有效方法,实验采取在线随机增强方式,对网络中批次抽取的样本进行旋转、图像水平偏移、垂直偏移、缩放和水平翻转等随机增强处理,这样的方式保证了每次训练过程的样本不完全相同,使训练得到的模型具有更好的泛化能力,防止过拟合。

本文提出的U-Net+模型结构如图 3所示(其中,D为dropout)。

2.2 模型实验

实验硬件CPU为英特尔Corei7-8700@3.20 GHz,GPU为NVIDIA GeForce RTX 2080 Ti 11 GB,采用TensorFlow后端的Keras深度学习框架实现U-Net+模型的搭建与实验。

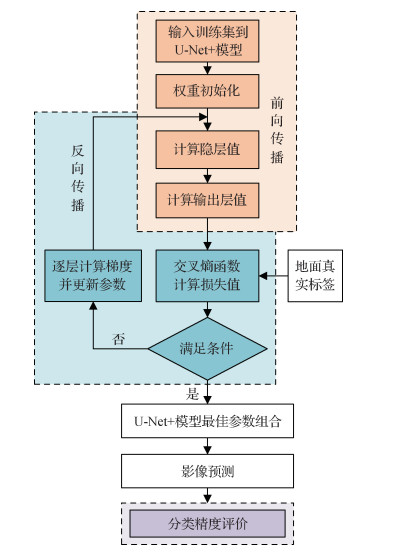

在模型训练中,共有1 500幅256 × 256像素的训练图像、500幅测试图像和对应标签输入模型,初始学习率为0.001,最大迭代次数100次,每次训练的主要步骤如下:

1) 在训练集中每批次(batch size)随机抽取2组训练样本x和对应标签

2) 训练样本输入网络后进行前向传播(forward pass),在编码部分提取输入影像的特征,在解码部分恢复其空间位置与分辨率,在像素分类层对每一像素进行绿地分类获得4种类别信息,得到一组预测值

3) 采用交叉熵函数计算这批数据的损失值,用于衡量标签

4) 通过Adam优化器,计算损失值相对于网络参数的梯度,将参数进行反向传播(backward pass),从而降低损失值。

按照上述步骤反复循环,经过100次迭代,计算机逐层优化模型中的参数达到最优,损失函数降到0.02,此时训练结束。将待分类影像输入网络进行预测,获得最终分类结果图。

2.3 分类后精度评价

为定量评估影像分类精度,采用混淆矩阵(郑明国等,2006)对分类后影像全部像元进行类别统计,并将总体分类精度(overall accuracy,OA)、kappa系数和F1分数作为评价指标。

OA表示全部像素分类结果与标签数据对应区域的实际类型一致的概率。kappa系数(K)表示分类与完全随机分类产生错误减少的比例。具体为

| $ {OA = \sum\limits_{i = 1}^n {\frac{{{x_{ii}}}}{N}} } $ | (1) |

| $ {K = \frac{{N\sum\limits_{i = 1}^n {{x_{ii}}} - \sum\limits_{i = 1}^n {\left({{x_{i + }}{x_{ + i}}} \right)} }}{{{N^2} - \sum\limits_{i = 1}^n {\left({{x_{i + }}{x_{ + i}}} \right)} }}} $ | (2) |

式中,

F1分数(

| $ F_{1}=\frac{\left(1+\beta^{2}\right) P \times R}{\beta^{2}(P+R)} $ | (3) |

式中,

U-Net+模型的技术流程如图 4所示。

3 结果与分析

3.1 模型训练结果

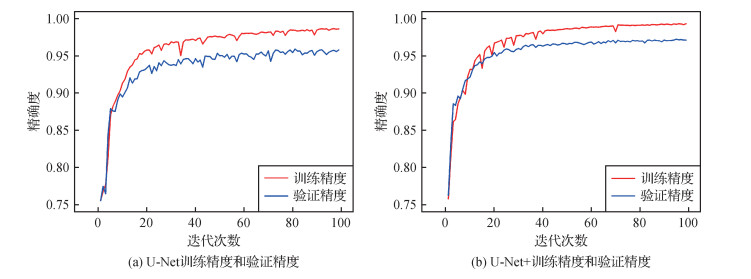

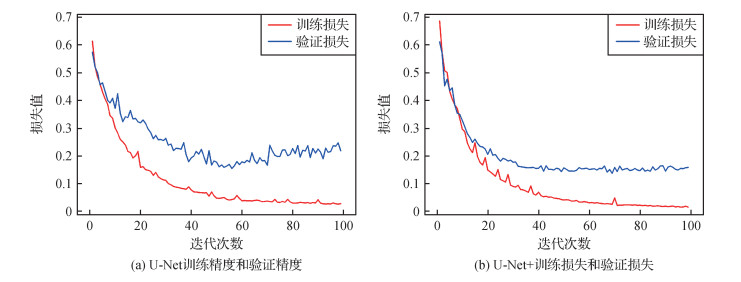

将1 500幅256 × 256像素的图像和对应标签输入原始U-Net和改进后的U-Net+模型中迭代100次,得到两组随迭代次数变化的精确度曲线和损失值曲线,如图 5和图 6所示。通过图 5和图 6对U-Net模型改进前后的训练情况和过拟合现象进行分析,可以看出在训练过程中,U-Net和U-Net+模型训练集和验证集的精确度均随迭代次数的增多先快速上升,迭代40次后逐渐升高趋于平稳,二者的整体变化趋势比较一致;U-Net和U-Net+模型训练集的损失值随迭代次数的增加先快速下降,迭代40次后逐渐降低趋近于0;U-Net模型验证集的损失值先保持稳步下降,迭代60次后loss出现上升趋势,说明模型存在过拟合现象;U-Net+模型验证集的损失值在前40次迭代时有显著下降,随后趋于平缓,损失值在0.16左右波动。训练结果表明,增加了BN、dropout和数据随机增强的U-Net+模型可以有效防止过拟合现象,提高了模型的泛化能力和鲁棒性。改进后的模型经过40次,迭代准确率已经达到较高水平,曲线相对平滑,波动性较小,说明学习率设置较为合理,损失函数实现快速收敛,可判定网络对数据集进行了有效学习。

将U-Net+模型预测的测试影像分类图进行混淆矩阵计算,结果如表 2所示。共有1 888 818个像元参与混淆矩阵计算,1 751 518个像元分类正确,kappa系数为0.89,总体分类精度为92.73%,相比U-Net模型提高了1.06%。在分类结果中,常绿树的分类精度最高(

表 2

U-Net+模型分类结果混淆矩阵与评价精度

Table 2

Confusion matrix and evaluation accuracies of classification results with U-Net+ model

| 标签 | 预测类型及数量 | 评价指标 | |||||||||

| 类型 | 数量 | 落叶树 | 常绿树 | 草地 | 其他 | 用户精度/% | 制图精度/% | 总体分类精度/% | kappa系数 | ||

| 落叶树 | 345 565 | 311 496 | 4 347 | 2 011 | 27 711 | 83.23 | 90.14 | 86.55 | |||

| 常绿树 | 341 859 | 11 552 | 316 866 | 824 | 12 617 | 94.64 | 92.69 | 93.65 | 92.73 | 0.89 | |

| 草地 | 173 243 | 8 269 | 1 029 | 158 587 | 5 358 | 93.58 | 91.54 | 92.55 | |||

| 其他 | 1 028 151 | 42 957 | 12 574 | 8 051 | 964 569 | 95.48 | 93.82 | 94.64 | |||

| 注:加粗字体为各列预测正确的数量。 | |||||||||||

3.2 地物分类结果对比

为验证本文方法的有效性,与MLE(maximum likelihood estimation)(金杰等,2014)、NNs(neural networks)(Pacifici等,2009)、SVM(support vector maohine)(Liu等,2017)等传统分类方法和SegNet(Badrinarayanan等,2017)、DeepLabv3+(Chen等,2018)、U-Net (Ronneberger等,2015)等语义分割模型进行对比实验,MLE、NNs和SVM的分类实验均在ENVI(environment for visualizing images)软件中完成。

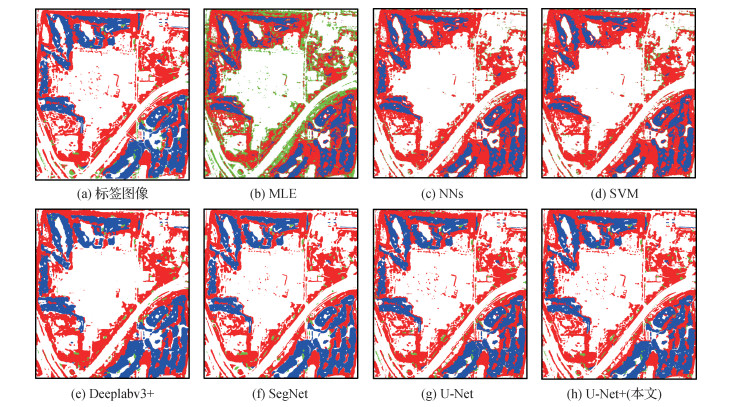

图 7为本文方法和6种比较方法对城市公园遥感影像分类的结果图。可以看出,SVM、MLE和NNs等传统分类方法错分漏分现象严重,呈现出以下共性:1)对分布较为规则集中的常绿树的分类效果略好,对西南角居民区内分布较为零散的落叶树误分现象严重;2)草地在3种绿地类型中面积占比最小,光谱特征与落叶树相似,分类精度最差,其中NNs未能识别出草地;3)MLE由于高分辨率遥感影像类内差异大,存在同物异谱和同谱异物现象,落叶树与草地混淆现象较为严重,存在明显的“椒盐噪声”;4)SVM在高分影像城市绿地分类中未发挥优势,对3种绿地的提取效果一般。相比之下,SegNet、DeepLabv3+和U-Net等深度学习模型在高分影像城市绿地分类中更具优势,3种方法均能有效抑制地物混分现象,降低了分类过程中出现的“椒盐噪声”。相比SegNet和DeepLabv3+模型的分类结果,U-Net模型对城市绿地的细节信息表达更精确,边界与真实绿地更吻合,且对两种以上混交绿地也能较好区分,例如排列整齐的树林间隙中的草地也能够实现有效提取。在7种分类方法中,本文提出的U-Net+模型的分类精度最好,在U-Net模型的基础上总体提高了0.85%。

表 3为本文方法和6种比较方法对城市公园遥感影像分类的精度对比。可以看出,按总体分类精度(OA)排序,分类效果依次为U-Net+(93.80%)、U-Net(92.95%)、SegNet(87.31%)、DeepLabv3+(84.51%)、SVM (77.94%)、MLE(76.25%)和NNs(75.85%)。显然,本文提出的U-Net+模型的分类精度最优。

表 3

不同方法对城市公园遥感影像分类精度对比

Table 3

Comparison of classification accuracies of urban parks remote sensing images among different methods

| 方法 | OA/% | kappa系数 | |||||

| 落叶树 | 常绿树 | 草地 | 其他 | 平均 | |||

| MLE | 57.22 | 83.21 | 36.74 | 76.04 | 63.3 | 76.25 | 0.61 |

| NNs | 61.89 | 83.53 | 0.00 | 72.81 | 54.56 | 75.85 | 0.60 |

| SVM | 62.77 | 82.81 | 23.54 | 78.71 | 61.96 | 77.94 | 0.63 |

| DeepLabv3+ | 75.65 | 89.40 | 59.33 | 81.73 | 76.53 | 84.51 | 0.74 |

| SegNet | 84.54 | 90.88 | 67.32 | 84.68 | 81.86 | 87.31 | 0.79 |

| U-Net | 85.72 | 95.89 | 73.18 | 92.53 | 86.83 | 92.95 | 0.88 |

| U-Net+(本文) | 88.40 | 96.21 | 81.25 | 93.08 | 89.73 | 93.80 | 0.90 |

| 注:加粗字体表示各列最优结果。 | |||||||

图 8为本文方法和6种比较方法对高尔夫球场遥感影像分类的结果图。高尔夫球场主要以种植人工草地为主,因此草地在3种绿地类型中的辨识度最高,分类精度较优;常绿树在3种绿地类型中种植面积最小,错分漏分现象严重,从图 8(b)可以看出常绿树面积异常增多;中部地区(六郎庄烈士陵园)分布着许多细碎的落叶树斑块,传统分类方法和DeepLabv3+均未能有效识别,SegNet模型能够识别出破碎的绿地图斑,但是识别效果低于U-Net模型。在7种分类方法中,本文提出的U-Net+模型在高尔夫球场遥感影像分类中表现最优异,不同类别边界规则且清晰,草地的

表 4为本文方法和6种比较方法对高尔夫球场遥感影像分类的精度对比。可以看出,按总体分类精度(OA)排序,分类效果依次为U-Net+(87.15%)、U-Net(85.44%)、SegNet(84.60%)、DeepLabv3+(83.14%)、NNs(77.21%)、SVM(76.72%)和MLE (70.64%)。显然,本文提出的U-Net+模型的分类精度依然最优。

表 4

不同方法对高尔夫球场遥感影像分类精度对比

Table 4

Comparison of classification accuracies of golf courses remote sensing images among different methods

| 方法 | OA/% | kappa系数 | |||||

| 落叶树 | 常绿树 | 草地 | 其他 | 平均 | |||

| MLE | 65.64 | 17.22 | 79.09 | 82.18 | 61.03 | 70.64 | 0.59 |

| NNs | 69.11 | 9.46 | 78.50 | 86.74 | 60.95 | 77.21 | 0.66 |

| SVM | 68.64 | 12.02 | 76.80 | 86.89 | 61.09 | 76.72 | 0.65 |

| DeepLabv3+ | 78.91 | 24.43 | 90.08 | 85.11 | 69.63 | 83.14 | 0.75 |

| SegNet | 81.48 | 31.65 | 91.22 | 86.21 | 72.64 | 84.60 | 0.77 |

| U-Net | 81.04 | 38.00 | 92.06 | 87.84 | 74.73 | 85.44 | 0.78 |

| U-Net+(本文) | 83.40 | 44.02 | 93.64 | 88.52 | 77.39 | 87.15 | 0.81 |

| 注:加粗字体表示各列最优结果。 | |||||||

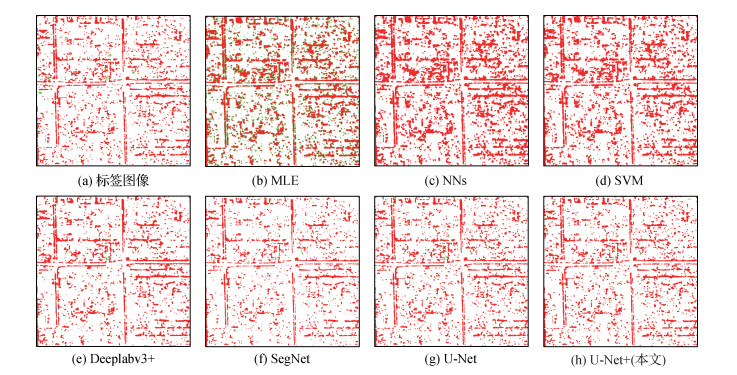

图 9为本文方法和6种比较方法对住宅区遥感影像分类的结果图。住宅区绿地主要包括住宅小区庭院绿地、花园绿地和城市道路等交通运输用地中的附属绿地,分布较破碎零散,主要以落叶树为主,常绿树为辅,草地类型极少。从图 9可以看出,MLE分类结果中常绿树出现大量错分现象,3种传统分类结果中落叶树的

表 5为本文方法和6种比较方法对住宅区遥感影像分类的精度对比。可以看出,按总体分类精度(OA)排序,分类效果依次为U-Net+(96.92%)、U-Net(96.28%)、SegNet (94.79%)、DeepLabv3+(94.34%)、SVM (89.04%)、NNs(86.55%)和MLE(84.36%)。显然,本文提出的U-Net+模型的分类精度最优。

表 5

不同方法对住宅区遥感影像分类精度对比

Table 5

Comparison of classification accuracies of residential areas remote sensing images among different methods

| 方法 | OA/% | kappa系数 | |||||

| 落叶树 | 常绿树 | 草地 | 其他 | 平均 | |||

| MLE | 77.31 | - | - | 90.23 | 83.77 | 84.36 | 0.59 |

| NNs | 70.00 | - | - | 91.34 | 80.67 | 86.55 | 0.62 |

| SVM | 73.93 | - | - | 93.07 | 83.50 | 89.04 | 0.67 |

| DeepLabv3+ | 82.79 | - | - | 96.64 | 89.72 | 94.34 | 0.79 |

| SegNet | 82.00 | - | - | 96.96 | 89.48 | 94.79 | 0.79 |

| U-Net | 88.52 | - | - | 97.81 | 93.16 | 96.28 | 0.86 |

| U-Net+(本文) | 90.57 | - | - | 98.18 | 94.38 | 96.92 | 0.89 |

| 注:加粗字体表示各列最优结果。“-”表示测试集中无该类型。 | |||||||

通过上述对比分析,得出以下结论:面对高分辨率遥感影像,基于深度学习技术的遥感分类方法相比传统机器学习算法能得到更优异的城市绿地遥感影像分类结果。MLE、NNs和SVM等方法属于机器学习较浅层的学习算法,受计算单元限制,无法扩展到大型数据集解决较为复杂的分类问题;而U-Net+、U-Net、SegNet和DeepLabv3+等深度学习网络模型能将城市绿地遥感影像进行较好的分类,在于其能够更充分地挖掘海量数据的深层信息,更好地进行特征工程构建,对高维复杂问题进行函数表达,其分类结果不仅有效抑制了像素级分类过程中易产生的椒盐噪声,而且在一定程度上减少了地物像元混分现象。通过对比实验证明,本文采用的U-Net+模型在3个验证区的7种方法中总体分类精度最优,相比U-Net模型分类精度有一定程度的提高,说明该方法能够有效提升高分辨率城市绿地遥感影像分类提取精度,为今后城市绿地遥感影像分类提供了一种新的智能解译方法。

同时,实验结果发现,深度学习方法在城市绿地遥感影像分类过程中具有一定的容错能力。在标签数据制作时,由于人工目视解译费时费力,难免存在误判现象,样本的选取不能保证百分之百正确。图 10展示了深度学习样本的容错性。可以看出,第1行影像中的落叶树在目视解译时出现混淆像元,U-Net+的预测结果排除了这部分错误信息,预测结果更加接近真实地物;第2行影像中的道路周边零散分布的常绿树在目视解译时未采集,但U-Net+模型的预测结果却得到了有效表达,说明深度学习模型对训练样本具有较强的容错能力,通过对大量标签数据训练学习,能够像人脑一样“去伪存真”,有效减少误差的影响,提高识别能力。

4 结论

本文将深度学习卷积神经网络应用于高分辨率城市绿地遥感影像分类。由于人工构建深度学习标签数据集困难,为解决小样本数据集不足可能带来的模型过拟合问题,本文对U-Net网络架构进行改进得到U-Net+模型。在此基础上,选取北京市城市公园、住宅区和高尔夫球场等3个典型城市绿地样本区进行7组不同分类模型的实验对比。实验结果证明,添加BN层、dropout层和随机数据增强处理可以有效防止模型过拟合,提高了模型的泛化能力和鲁棒性。本文方法的总体分类精度为92.73%、kappa系数为0.89、平均F1分数为91.85%。7种分类方法按照总体分类精度从大到小排序依次为U-Net+(92.73%)、U-Net(91.67%)、SegNet(88.98%)、DeepLabv3+(87.41%)、SVM(81.32%)、NNs(79.92%)和MLE(77.21%)。本文方法分类效果显著优于MLE、NNs和SVM等浅层机器学习分类算法,较优于DeepLabv3+和SegNet等深度学习模型,与U-Net模型相比,总体分类精度提升了1.06%。本文方法有效克服了传统分类过程中的“椒盐现象”,实现了城市绿地遥感影像的高精度像素级分类。此外,深度学习模型对训练样本具有较强的容错能力,有效减少了误差的影响,提高了不同绿地遥感影像类型的识别能力。通过对比实验证明,U-Net+卷积神经网络在精细化的城市绿地遥感影像分类提取中具有较强的可行性和准确性,为今后开展城市绿地遥感影像信息调查提供了一种高效的智能解译方法。

深度学习方法的学习能力和泛化能力强,能够从海量高分辨率遥感影像中挖掘待分地物光谱、纹理、形状等潜在的特征信息,自动构建特征工程,解决了高分辨率城市绿地遥感影像在分类中的异质性和类内差异等一系列问题。然而,分类效果的好坏还受到数据质量的影响,由于高分辨率遥感影像波段数有限,在一定程度上限制了特征学习的丰富度。在后续研究中,将尝试扩展多个通道来补充多源数据,例如增加植被特征来提高模型的分类精度;同时,本文模型属于基础性模型,后期工作将从模型的架构模式、损失函数等方面进一步提高模型性能。

参考文献

-

Badrinarayanan V, Kendall A, Cipolla R. 2017. SegNet: a deep convolutional encoder-decoder architecture for image Segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 39(12): 2481-2495 [DOI:10.1109/TPAMI.2016.2644615]

-

Beijing Municipal Institute of city Planning and Design. 2010. Planning of green space system in Beijing[EB/OL].[2020-02-19]. http://yllhj.beijing.gov.cn/zwgk/ghxx/gh/201911/P0201911295-02960993686.pdf (北京市城市规划设计研究院. 2010. 北京市绿地系统规划[EB/OL]. [2020-02-19]. http://yllhj.beijing.gov.cn/zwgk/ghxx/gh/201911/P020191129502960993686.pdf)

-

Chen L C, Zhu Y K, Papandreou G, Schroff F and Adam H. 2018. Encoder-decoder with atrous separable convolution for semantic image segmentation//Proceedings of the 15th European Conference on Computer Vision. Munich, Germany: Springer: 833-851[DOI: 10.1007/978-3-030-01234-2_49]

-

Diakogiannis F I, Waldner F, Caccetta P, Wu C. 2020. ResUNet-a: a deep learning framework for semantic segmentation of remotely sensed data. ISPRS Journal of Photogrammetry and Remote Sensing, 162: 94-114 [DOI:10.1016/j.isprsjprs.2020.01.013]

-

Helber P, Bischke B, Dengel A and Borth D. 2018. Introducing EuroSAT: a novel dataset and deep learning benchmark for land use and land cover classification//2018 IEEE International Geoscience and Remote Sensing Symposium. Valencia, Spain: IEEE: 204-207[DOI: 10.1109/IGARSS.2018.8519248]

-

Hinton G E, Osindero S, Teh Y W. 2006. A fast learning algorithm for deep belief nets. Neural Computation, 18(7): 1527-1554 [DOI:10.1162/neco.2006.18.7.1527]

-

Hirasawa T, Aoyama K, Tanimoto T, Ishihara S, Ozawa T, Ohnishi T, Fujishiro M, Matsuo K, Fujisaki J, Tada T. 2018. Application of artificial intelligence using a convolutional neural network for detecting gastric cancer in endoscopic images. Gastric Cancer, 21(4): 653-660 [DOI:10.1007/s10120-018-0793-2]

-

Ioffe S and Szegedy C. 2015. Batch normalization: accelerating deep network training by reducing internal covariate shift[EB/OL].[2020-02-19]. https://arxiv.org/pdf/1502.03167.pdf

-

Jin J, Zhu H Y, Li Z X, Sun J W. 2014. The comparison of several kinds of supervised classification methods in ENVI remote sensing image processing. Water Conservancy Science and Technology and Economy, 20(1): 146-148, 160 (金杰, 朱海岩, 李子潇, 孙建伟. 2014. ENVI遥感图像处理中几种监督分类方法的比较. 水利科技与经济, 20(1): 146-148, 160) [DOI:10.3969/j.issn.1006-7175.2014.01.058]

-

Kussul N, Lavreniuk M, Skakun S, Shelestov A. 2017. Deep learning classification of land cover and crop types using remote sensing data. IEEE Geoscience and Remote Sensing Letters, 14(5): 778-782 [DOI:10.1109/LGRS.2017.2681128]

-

Li R R, Liu W J, Yang L, Sun S H, Hu W, Zhang F, Li W. 2018. DeepUNet: a deep fully convolutional network for pixel-level sea-land segmentation. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 11(11): 3954-3962 [DOI:10.1109/JSTARS.2018.2833382]

-

Lin T Y, Goyal P, Girshick R, He K M and Dollár P. 2017. Focal loss for dense object detection//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy: IEEE: 2999-3007[DOI: 10.1109/iccv.2017.324]

-

Liu D W, Han L, Han X Y. 2016. High spatial resolution remote sensing image classification based on deep learning. Acta Optica Sinica, 36(4): #0428001 (刘大伟, 韩玲, 韩晓勇. 2016. 基于深度学习的高分辨率遥感影像分类研究. 光学学报, 36(4): #0428001) [DOI:10.3788/AOS201636.0428001]

-

Liu H, Luo J C, Huang B, Hu X D, Sun Y W, Yang Y P, Xu N, Zhou N. 2019. DE-Net: deep encoding network for building extraction from high-resolution remote sensing imagery. Remote Sensing, 11(20): #2380 [DOI:10.3390/rs11202380]

-

Liu P, Choo K K R, Wang L Z, Huang F. 2017. SVM or deep learning? A comparative study on remote sensing image classification. Soft Computing, 21(23): 7053-7065 [DOI:10.1007/s00500-016-2247-2]

-

Long J, Shelhamer E and Darrell T. 2015. Fully convolutional networks for semantic segmentation//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA: IEEE: 3431-3440[DOI: 10.1109/CVPR.2015.7298965]

-

Pacifici F, Chini M, Emery W J. 2009. A neural network approach using multi-scale textural metrics from very high-resolution panchromatic imagery for urban land-use classification. Remote Sensing of Environment, 113(6): 1276-1292 [DOI:10.1016/j.rse.2009.02.014]

-

Qian Y G, Zhou W Q, Li W F, Han L J. 2015. Understanding the dynamic of greenspace in the urbanized area of Beijing based on high resolution satellite images. Urban Forestry and Urban Greening, 14(1): 39-47 [DOI:10.1016/j.ufug.2014.11.006]

-

Ronneberger O, Fischer P and Brox T. 2015. U-Net: convolutional networks for biomedical image segmentation//Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich, Germany: Springer: 234-241[DOI: 10.1007/978-3-319-24574-4_28]

-

Srivastava N, Hinton G, Krizhevsky A, Sutskever I, Salakhutdinov R. 2014. Dropout: a simple way to prevent neural networks from overfitting. The Journal of Machine Learning Research, 15(1): 1929-1958

-

Wu L J. 2006. Studies on landscape pattern and biodiversity conservation of municipal open space in Beijing. Beijing: Beijing Forestry University (吴丽娟. 2006. 北京城市绿地景观格局与生物多样性保护研究. 北京: 北京林业大学)

-

Xu H M, Qi H, Nan K, Chen M. 2019. High-resolution remote sensing image classification by combining deep learning with nDSM. Bulletin of Surveying and Mapping, (8): 63-67 (许慧敏, 齐华, 南轲, 陈敏. 2019. 结合nDSM的高分辨率遥感影像深度学习分类方法. 测绘通报, (8): 63-67) [DOI:10.13474/j.cnki.11-2246.2019.0253]

-

Zhang Z X, Liu Q J, Wang Y H. 2018. Road extraction by deep residual U-Net. IEEE Geoscience and Remote Sensing Letters, 15(5): 749-753 [DOI:10.1109/LGRS.2018.2802944]

-

Zheng M G, Cai Q G, Qin M Z, Yue T X. 2006. A new approach to accuracy assessment of classifications of remotely sensed data. Journal of Remote Sensing, 10(1): 39-48 (郑明国, 蔡强国, 秦明周, 岳天祥. 2006. 一种遥感影像分类精度检验的新方法. 遥感学报, 10(1): 39-48) [DOI:10.11834/jrs.20060107]